- Функция Python предсказать () – все, что вам нужно знать!

- Функция Python предсказать () – все, что вам нужно знать!

- Понимание функции прогнозирования () в Python

- Реализация функции python предсказать ()

- Использование предсказания () функции с деревами решений

- Использование функции прогнозирования () с помощью алгоритма KNN

- Заключение

- Предсказание чего угодно с использованием Python

- Пошаговый классификатор на Python

- Как работает классификатор на Python

- Интерфейс

- Начало работы

- Реализация классификатора

- Обучение

- Предсказание классификатора

- Точность алгоритма

- Тестирование классификатора

- Breast Cancer

- Заключение

- Обзор методов классификации в машинном обучении с помощью Scikit-Learn

- Что такое Scikit-Learn?

- Основные термины

- Типы классификаторов

- Метод k-ближайших соседей (K-Nearest Neighbors)

- Классификатор дерева решений (Decision Tree Classifier)

- Наивный байесовский классификатор (Naive Bayes)

- Линейный дискриминантный анализ (Linear Discriminant Analysis)

- Метод опорных векторов (Support Vector Machines)

- Логистическая регрессия (Logistic Regression)

- Примеры задач классификации

- Реализация классификатора

- Процесс машинного обучения

- Реализация образца классификации

- Оценка классификатора

- Точность классификации

- Логарифмические потери

- Площадь ROC-кривой (AUC)

- Матрица неточностей

- Отчёт о классификации

- Заключение

Функция Python предсказать () – все, что вам нужно знать!

Эй, читатели! В этой статье мы будем сосредоточены на функции Python Presentict () подробно. Итак, давайте начнем сейчас !!

Автор: Pankaj Kumar

Дата записи

Функция Python предсказать () – все, что вам нужно знать!

Эй, читатели! В этой статье мы будем сосредоточиться на Python предсказать () Функция в деталях. Итак, давайте начнем сейчас !!

Понимание функции прогнозирования () в Python

В домене Наука данных , нам нужно применить различные модели обучения машины на наборах данных, чтобы тренировать данные. Далее, которые мы пытаемся предсказать значения для неподготовленных данных.

Это когда функция прогнозирования () входит в изображение.

Python предсказать () Функция позволяет нам Предсказать этикетки значений данных На основании обученной модели.

Синтаксис :

Функция предсказания () принимает только один аргумент Обычно это данные для проверки.

Он возвращает этикетки данных, переданных в качестве аргумента, основанного на выученных или обученных данных, полученных из модели.

Таким образом, функция прогнозирования () работает сверху обученной модели и использует выученную метку на карту и предсказывает этикетки для тестирования данных.

Реализация функции python предсказать ()

Сначала начните с загрузки набора данных в окружающую среду. Функция PandaS.READ_CSV позволяет нам загрузить набор данных из системы.

Вы можете найти набор данных здесь .

Поскольку набор данных содержит категорические переменные, а также созданные таблетки категорических функций для легкости в моделировании с использованием Pandas.get_Dummies () функция.

Далее у нас есть Разделите набор данных на тренировку и тестирование DataSet Использование rain_test_split () функция.

Теперь давайте сосредоточимся на реализации алгоритма для прогнозирования в предстоящем разделе.

Использование предсказания () функции с деревами решений

Теперь мы применили Алгоритм дерева решений На вышеуказанном разделенном наборе данных и использовали Прогнозировать () Функция Чтобы предсказать этикетки набора тестирования на основе данных на основе значений, предсказанных из модели дерева принятия решений.

Использование функции прогнозирования () с помощью алгоритма KNN

В этом примере мы использовали КНН АЛГОРИТММ делать прогнозы из набора данных. Мы применили Kneighborsregressor () Функция на учебных данных.

Кроме того, мы применили функцию предсказания () в отношении прогнозов на наборе данных тестирования.

Заключение

По этому, мы подошли к концу этой темы. Не стесняйтесь комментировать ниже, если вы столкнетесь с любыми вопросами!

Для большего количества таких постов, связанных с Python, оставайся мелодией и до тех пор, как потом, счастливое обучение !! 🙂.

Источник

Предсказание чего угодно с использованием Python

Небольшая статья с ресурса http://www.talaikis.com/ о построении простой стратегии, использующую наивный байесовский классификатор при создании процесса возврата к среднему. Весь код в статье приведен на языке Python.

Это достаточно большая область исследований, но расскажем все очень кратко. Мы попытаемся найти взаимоотношение между временными сериями (в данном случае возьмем в качестве сигнала взаимный фонд XLF из финансового сектора, сдвинутый по времени на 1 день назад), а нашей целью будет фьючерс S&P500 в форме CFD. Будем входить в длинную позицию по этой бумаге при нулевой вероятности приращения. Логически нулевая вероятность ни о чем не говорит, другими словами, будем покупать возврат к среднему.

1. Получение данных

2. Далее мы конструируем матрицу ошибок.Если сигнал растет и S&P500 растет — это истинное положительное значение, если сигнал вверх, а S&P500 -вниз, это ложное положительное значение, то же для отрицательных сигналов. Мы делаем это двумя способами:

3. Преобразуем сигналы в булевы переменные, используя скользящую сумму из 10 значений по всем сигналам:

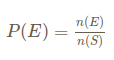

4. Теперь попытаемся определить вероятность сигналов обоих направлений. Для этого используем простую формулу частот:

смысл которой в том, что вероятность события равна числу желаемых событий, деленных на число всех возможных событий:

5. Вычислим вероятности противоположных событий:

6. Сейчас мы можем вычислить сигналы и прибыльность. Будем использовать десятикратное плечо при расчете прибыли. Код ниже дан для ситуации » вход в лонг при отрицательной вероятности»:

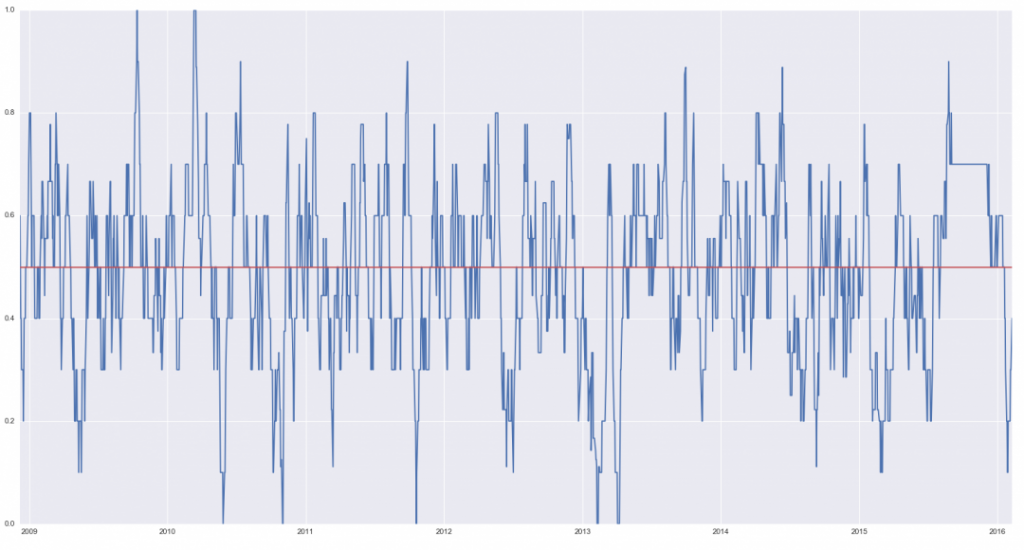

В заглавии статьи показан график кумулятивной прибыли по сравнению со стратегией «купил и держи» ( линия зеленого цвета).

Ниже — график просадок:

Конечно, векторизованный бэктест показывает только, как это было бы при входе и выходе на закрытии дня, не учитывает комиссий и т.п.

Источник

Пошаговый классификатор на Python

Добрый день, уважаемые читатели! Темой нашей сегодняшней статьи стал пошаговый классификатор, реализованный на чистом Python, использующий в качестве основы модель sklearn, а для вычислений NumPy.

А на моем YouTube-канале ты найдешь обучающие видео по программированию. Подписывайся!

Как работает классификатор на Python

Суть работы алгоритма довольно проста. Мы берём первую метку класса из всех, и преобразовываем набор данных следующим образом:

- все образцы, принадлежащие к выбранному классу, отныне относятся к классу 1

- все образцы, которые не принадлежат к выбранному классу будут относится к классу 0

Каждый раз мы будем проделывать такую операцию с разными метками классов, кроме «последней».

Интерфейс

В нашем классе мы реализуем программный интерфейс sklearn, а именно методы:

- fit — обучение (досл. адаптация) модели под обучающие данные

- prediсt — предсказание по определённому образцу

- score — вычислить долю верных предсказаний на определённом наборе образцов

Начало работы

Ниже приведён список всех модулей, которые нам необходимы:

Примечание. Не беспокойтесь по поводу копирования кода, в конце статьи будет ссылка на .ipynb-документ, который вы сможете изменить по своему усмотрению.

Разберёмся по порядку:

- copy.copy — т. к. наш классификатор основан на слабом ученике, то нам необходимо копировать модель, чтобы обучить новую.

- numpy — нам понадобится несколько функций из этой библиотеки. Также основой наших вычислений станет np.array.

- sklearn.datasets — отсюда мы возьмём наборы данных, на которых будем испытывать реализуемый алгоритм.

- sklearn.train_test_split — функция «разбора» набора данных на обучающую и проверочную выборки.

- sklearn.LogisticRegression — первый слабый ученик, который станет основой нашего алгоритм (название может сбить Вас с толку. Логистическая регрессия — алгоритм классификации 🙂 ).

- sklearn.neural_network — второй слабый ученик для классификатора.

Реализация классификатора

Обучение

Конструктор классификатора будет принимать лишь один аргумент — класс, в котором реализован алгоритм классификации, который мы будем обучать несколько раз:

Так же мы создадим булевое поле, отвечающее за то, является ли модель адаптированной и пустой список для хранения обученных моделей.

Метод, отвечающий за обучение модели, выглядит так:

Далее мы перебором по всем меткам обучаем алгоритм. С помощью выбора по маске (true_X = X[y == cl]), мы выбираем «положительные» и «отрицательные» образцы и обучаем новую модель на них. Здесь могут смутить только функции из модуля numpy.

- np.vstack — просто соединяет массивы вертикально, т. е. просто добавляет строки из второго массива в первый.

- np.concatenate — объединяет два одномерных массива в один (только здесь, подробнее про эту функцию вы можете почитать здесь).

В конце выставляем булевое поле True и возвращаем сам классификатор для возможности создания цепного интерфейса.

Предсказание классификатора

Здесь всё просто. Мы проходим циклом по всем моделям алгоритма: если она предсказывает 1, то мы возвращаем нужную метку; в противном случае продолжаем.

В конце возвращаем последнюю метку: она вернется, только если все модели «забраковали» текущий образец.

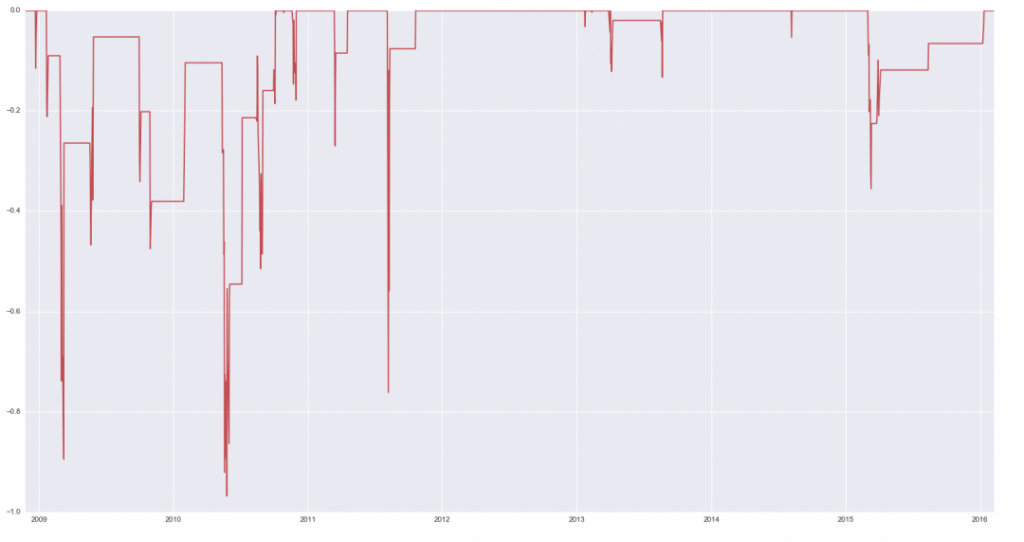

Точность алгоритма

Метод score работает так: он принимает набор образцов и меток к ним, а затем вычисляет соотношение правильно предсказанных меток к их общему кол-ву.

Да-да, метод score также принимает параметр измерения: в процентах или как обычная точность модели (от 0 до 1).

Тестирование классификатора

Мы протестируем наш алгоритм на двух наборах данных: всем известном Iris, а также на наборе Breast Cancer. Схема общая: инициализируем класс, предварительно передав в конструктор модель sklearn, разбиваем набор на обучающие и проверочные выборки и узнаём точность модели.

Как мы можем заметить, наш алгоритм с логистической регрессией без гиперпараметризации в виде слабого ученика показывает точность 93%. Довольно неплохо, но можно лучше.

Breast Cancer

Здесь мы использовали обычную нейросеть. Наш алгоритм показал точность даже выше, чем сама модель sklearn.

Заключение

Сегодня мы реализовали пошаговый классификатор, используя за основу модели sklearn, и добились неплохих результатов. Однако работа над алгоритмом не закончена, так что подкидываю Вам несколько идей:

- мы так и не реализовали булевое поле fitted. Подумайте, где бы оно могло пригодиться.

- нашу модель нельзя сохранить в какой-то файл. Реализуйте метод сохранения классификатора.

Весь код из статьи можно найти здесь.

Также рекомендую прочитать статью Нейросеть за пять минут! Is it real?! Подпишитесь на группу ВКонтакте, Telegram и YouTube-канал. Там еще больше полезного и интересного для разработчиков.

Источник

Обзор методов классификации в машинном обучении с помощью Scikit-Learn

Для машинного обучения на Python написано очень много библиотек. Сегодня мы рассмотрим одну из самых популярных — Scikit-Learn.

Scikit-Learn упрощает процесс создания классификатора и помогает более чётко выделить концепции машинного обучения, реализуя их с помощью понятной, хорошо документированной и надёжной библиотекой.

Что такое Scikit-Learn?

Scikit-Learn — это Python-библиотека, впервые разработанная David Cournapeau в 2007 году. В этой библиотеке находится большое количество алгоритмов для задач, связанных с классификацией и машинным обучением в целом.

Scikit-Learn базируется на библиотеке SciPy, которую нужно установить перед началом работы.

Основные термины

В системах машинного обучения или же системах нейросетей существуют входы и выходы. То, что подаётся на входы, принято называть признаками (англ. features).

27 июля в 19:00, Онлайн, Беcплатно

Признаки по существу являются тем же, что и переменные в научном эксперименте — они характеризуют какой-либо наблюдаемый феномен и их можно как-то количественно измерить.

Когда признаки подаются на входы системы машинного обучения, эта система пытается найти совпадения, заметить закономерность между признаками. На выходе генерируется результат этой работы.

Этот результат принято называть меткой (англ. label), поскольку у выходов есть некая пометка, выданная им системой, т. е. предположение (прогноз) о том, в какую категорию попадает выход после классификации.

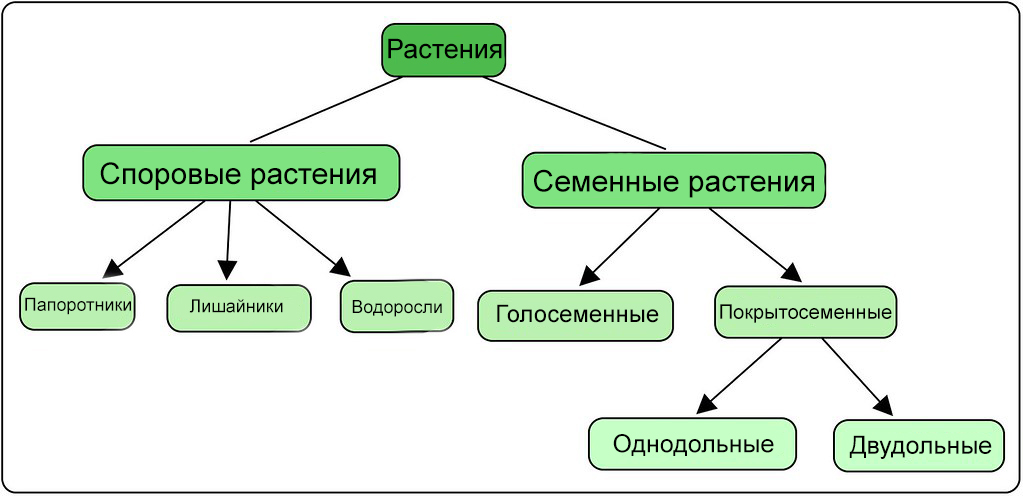

В контексте машинного обучения классификация относится к обучению с учителем. Такой тип обучения подразумевает, что данные, подаваемые на входы системы, уже помечены, а важная часть признаков уже разделена на отдельные категории или классы. Поэтому сеть уже знает, какая часть входов важна, а какую часть можно самостоятельно проверить. Пример классификации — сортировка различных растений на группы, например «папоротники» и «покрытосеменные». Подобная задача может быть выполнена с помощью Дерева Решений — одного из типов классификатора в Scikit-Learn.

При обучении без учителя в систему подаются непомеченные данные, и она должна попытаться сама разделить эти данные на категории. Так как классификация относится к типу обучения с учителем, способ обучения без учителя в этой статье рассматриваться не будет.

Процесс обучения модели — это подача данных для нейросети, которая в результате должна вывести определённые шаблоны для данных. В процессе обучения модели с учителем на вход подаются признаки и метки, а при прогнозировании на вход классификатора подаются только признаки.

Принимаемые сетью данные делятся на две группы: набор данных для обучения и набор для тестирования. Не стоит проверять сеть на том же наборе данных, на которых она обучалась, т. к. модель уже будет «заточена» под этот набор.

Типы классификаторов

Scikit-Learn даёт доступ ко множеству различных алгоритмов классификации. Вот основные из них:

На сайте Scikit-Learn есть много литературы на тему этих алгоритмов с кратким пояснением работы каждого из них.

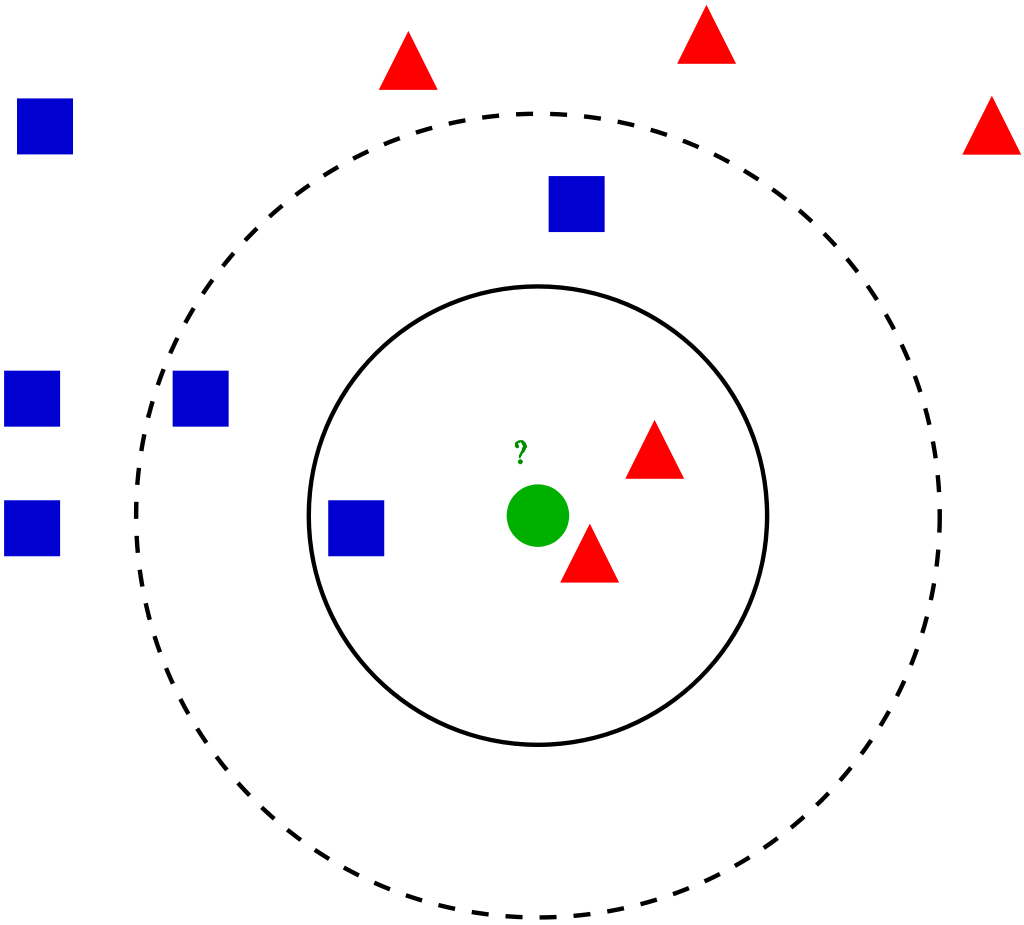

Метод k-ближайших соседей (K-Nearest Neighbors)

Этот метод работает с помощью поиска кратчайшей дистанции между тестируемым объектом и ближайшими к нему классифицированным объектами из обучающего набора. Классифицируемый объект будет относится к тому классу, к которому принадлежит ближайший объект набора.

Классификатор дерева решений (Decision Tree Classifier)

Этот классификатор разбивает данные на всё меньшие и меньшие подмножества на основе разных критериев, т. е. у каждого подмножества своя сортирующая категория. С каждым разделением количество объектов определённого критерия уменьшается.

Классификация подойдёт к концу, когда сеть дойдёт до подмножества только с одним объектом. Если объединить несколько подобных деревьев решений, то получится так называемый Случайный Лес (англ. Random Forest).

Наивный байесовский классификатор (Naive Bayes)

Такой классификатор вычисляет вероятность принадлежности объекта к какому-то классу. Эта вероятность вычисляется из шанса, что какое-то событие произойдёт, с опорой на уже на произошедшие события.

Каждый параметр классифицируемого объекта считается независимым от других параметров.

Линейный дискриминантный анализ (Linear Discriminant Analysis)

Этот метод работает путём уменьшения размерности набора данных, проецируя все точки данных на линию. Потом он комбинирует эти точки в классы, базируясь на их расстоянии от центральной точки.

Этот метод, как можно уже догадаться, относится к линейным алгоритмам классификации, т. е. он хорошо подходит для данных с линейной зависимостью.

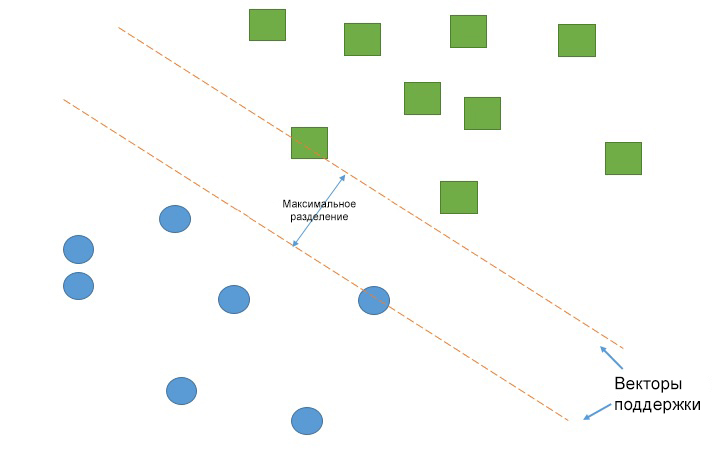

Метод опорных векторов (Support Vector Machines)

Работа метода опорных векторов заключается в рисовании линии между разными кластерами точек, которые нужно сгруппировать в классы. С одной стороны линии будут точки, принадлежащие одному классу, с другой стороны — к другому классу.

Классификатор будет пытаться увеличить расстояние между рисуемыми линиями и точками на разных сторонах, чтобы увеличить свою «уверенность» определения класса. Когда все точки построены, сторона, на которую они падают — это класс, которому эти точки принадлежат.

Логистическая регрессия (Logistic Regression)

Логистическая регрессия выводит прогнозы о точках в бинарном масштабе — нулевом или единичном. Если значение чего-либо равно либо больше 0.5 , то объект классифицируется в большую сторону (к единице). Если значение меньше 0.5 — в меньшую (к нулю).

У каждого признака есть своя метка, равная только 0 или только 1. Логистическая регрессия является линейным классификатором и поэтому используется, когда в данных прослеживается какая-то линейная зависимость.

Примеры задач классификации

Задача классификации — эта любая задача, где нужно определить тип объекта из двух и более существующих классов. Такие задачи могут быть разными: определение, кошка на изображении или собака, или определение качества вина на основе его кислотности и содержания алкоголя.

В зависимости от задачи классификации вы будете использовать разные типы классификаторов. Например, если классификация содержит какую-то бинарную логику, то к ней лучше всего подойдёт логистическая регрессия.

По мере накопления опыта вам будет проще выбирать подходящий тип классификатора. Однако хорошей практикой является реализация нескольких подходящих классификаторов и выбор наиболее оптимального и производительного.

Реализация классификатора

Первый шаг в реализации классификатора — его импорт в Python. Вот как это выглядит для логистической регрессии:

Вот импорты остальных классификаторов, рассмотренных выше:

Однако, это не все классификаторы, которые есть в Scikit-Learn. Про остальные можно прочитать на соответствующей странице в документации.

После этого нужно создать экземпляр классификатора. Сделать это можно создав переменную и вызвав функцию, связанную с классификатором.

Теперь классификатор нужно обучить. Перед этим нужно «подогнать» его под тренировочные данные.

Обучающие признаки и метки помещаются в классификатор через функцию fit :

После обучения модели данные уже можно подавать в классификатор. Это можно сделать через функцию классификатора predict , передав ей параметр (признак) для прогнозирования:

Эти этапы (создание экземпляра, обучение и классификация) являются основными при работе с классификаторами в Scikit-Learn. Но эта библиотека может управлять не только классификаторами, но и самими данными. Чтобы разобраться в том, как данные и классификатор работают вместе над задачей классификации, нужно разобраться в процессах машинного обучения в целом.

Процесс машинного обучения

Процесс содержит в себе следующие этапы: подготовка данных, создание обучающих наборов, создание классификатора, обучение классификатора, составление прогнозов, оценка производительности классификатора и настройка параметров.

Во-первых, нужно подготовить набор данных для классификатора — преобразовать данные в корректную для классификации форму и обработать любые аномалии в этих данных. Отсутствие значений в данных либо любые другие отклонения — все их нужно обработать, иначе они могут негативно влиять на производительность классификатора. Этот этап называется предварительной обработкой данных (англ. data preprocessing).

Следующим шагом будет разделение данных на обучающие и тестовые наборы. Для этого в Scikit-Learn существует отличная функция traintestsplit.

Как уже было сказано выше, классификатор должен быть создан и обучен на тренировочном наборе данных. После этих шагов модель уже может делать прогнозы. Сравнивая показания классификатора с фактически известными данными, можно делать вывод о точности классификатора.

Вероятнее всего, вам нужно будет «корректировать» параметры классификатора, пока вы не достигните желаемой точности (т. к. маловероятно, что классификатор будет соответствовать всем вашим требованиям с первого же запуска).

Ниже будет представлен пример работы машинного обучения от обработки данных и до оценки.

Реализация образца классификации

Поскольку набор данных iris достаточно распространён, в Scikit-Learn он уже присутствует, достаточно лишь заложить эту команду:

Тем не менее, тут ещё нужно подгрузить CSV-файл, который можно скачать здесь.

Этот файл нужно поместить в ту же папку, что и Python-файл. В библиотеке Pandas есть функция read_csv() , которая отлично работает с загрузкой данных.

Благодаря тому, что данные уже были подготовлены, долгой предварительной обработки они не требуют. Единственное, что может понадобиться — убрать ненужные столбцы (например ID ) таким образом:

Теперь нужно определить признаки и метки. С библиотекой Pandas можно легко «нарезать» таблицу и выбрать определённые строки/столбцы с помощью функции iloc() :

Код выше выбирает каждую строку и столбец, обрезав при этом последний столбец.

Выбрать признаки интересующего вас набора данных можно также передав в скобках заголовки столбцов:

После того, как вы выбрали нужные признаки и метки, их можно разделить на тренировочные и тестовые наборы, используя функцию train_test_split() :

Чтобы убедиться в правильности обработки данных, используйте:

Теперь можно создавать экземпляр классификатора, например метод опорных векторов и метод k-ближайших соседей:

Теперь нужно обучить эти два классификатора:

Эти команды обучили модели и теперь классификаторы могут делать прогнозы и сохранять результат в какую-либо переменную.

Теперь пришло время оценить точности классификатора. Существует несколько способов это сделать.

Нужно передать показания прогноза относительно фактически верных меток, значения которых были сохранены ранее.

Вот, к примеру, результат полученных метрик:

Поначалу кажется, что KNN работает точнее. Вот матрица неточностей для SVC:

Количество правильных прогнозов идёт с верхнего левого угла в нижний правый. Вот для сравнения метрики классификации для KNN:

Оценка классификатора

Когда дело доходит до оценки точности классификатора, есть несколько вариантов.

Точность классификации

Точность классификации измерять проще всего, и поэтому этот параметр чаще всего используется. Значение точности — это число правильных прогнозов, делённое на число всех прогнозов или, проще говоря, отношение правильных прогнозов ко всем.

Хоть этот показатель и может быстро дать вам явное представление о производительности классификатора, его лучше использовать, когда каждый класс имеет хотя бы примерно одинаковое количество примеров. Так как такое будет случаться редко, рекомендуется использовать другие показатели классификации.

Логарифмические потери

Значение Логарифмических Потерь (англ. Logarithmic Loss) — или просто логлосс — показывает, насколько классификатор «уверен» в своём прогнозе. Логлосс возвращает вероятность принадлежности объекта к тому или иному классу, суммируя их, чтобы дать общее представление об «уверенности» классификатора.

Этот показатель лежит в промежутке от 0 до 1 — «совсем не уверен» и «полностью уверен» соответственно. Логлосс сильно падает, когда классификатор сильно «уверен» в неправильном ответе.

Площадь ROC-кривой (AUC)

Такой показатель используется только при бинарной классификации. Площадь под ROC-кривой представляет способность классификатора различать подходящие и не подходящие какому-либо классу объекты.

Значение 1.0 : вся область, попадающая под кривую, представляет собой идеальный классификатор. Следовательно, 0.5 означает, что точность классификатора соответствует случайности. Кривая рассчитывается с учётом точности и специфичности модели. Подробнее о расчётах можно прочитать здесь.

Матрица неточностей

Матрица неточностей (англ. Confusion Matrix) — это таблица или диаграмма, показывающая точность прогнозирования классификатора в отношении двух и более классов. Прогнозы классификатора находятся на оси X, а результат (точность) — на оси Y.

Ячейки таблицы заполняются количеством прогнозов классификатора. Правильные прогнозы идут по диагонали от верхнего левого угла в нижний правый. Про это можно почитать в данной статье.

Отчёт о классификации

В библиотеке Scikit-Learn уже встроена возможность создавать отчёты о производительности классификатора. Эти отчёты дают интуитивно понятное представление о работе модели.

Заключение

Чтобы лучше вникнуть в работу с Scikit-Learn, неплохо было бы узнать больше о работе различных методов классификации. После этого стоит лучше узнать о замере производительности классификаторов. Однако понимание многих нюансов в классификации приходит только со временем.

Источник